Prove standardizzate cantonali: Matematica e Italiano in V SE

2022-02-18

Capitolo 1 Il progetto

Il presente rapporto fa seguito a tre rapporti analoghi prodotti negli anni. Il primo sulla base dei risultati alle prove di matematica in IV elementare (CIRSE 2014), il secondo alle prove di matematica in V elementare (Crescentini 2017b) e il terzo alle prove di italiano in III elementare (Crescentini 2017a).

Per quanto riguarda le informazioni utilizzate in questo rapporto specifico il progetto che le ha prodotte nel suo insieme si è svolto, nelle sue varie parti, negli anni scolastici dal 2019 al 2021.

L’insieme delle valutazioni svolte tramite le prove standardizzate che sono state costruite nell’ambito di questo progetto ha il duplice obiettivo di fornire delle informazioni di monitoraggio del sistema educativo (oggetto specifico di questo rapporto) e di fornire ai docenti, direttori e ispettori delle informazioni di dettaglio relative all’andamento delle specifiche classi, rispettivamente sedi e ispettorati.

Lo svolgimento del progetto e la struttura di massima del rapporto riprendono quelli degli altri rapporti. La presentazione dei contenuti e le dimensioni teoriche sono molto simili e si rimanda per gli approfondimenti del caso ai documenti già esistenti; alcune parti che si riteneva potessero giovare alla lettura ancorché già esistenti sono state messe in appendice.

I primi mesi del progetto sono stati impiegati per il consolidamento e sviluppo della rete di collaborazione. Questa è stata composta dal gruppo di esperti del territorio (in questo caso il termine non fa riferimento esclusivo agli esperti disciplinari della Scuola Media bensì a persone che fossero portatori di un sapere e di una conoscenza utile alla riflessione su questo oggetto), individuati grazie alla collaborazione con la Sezione delle scuole comunali (SESCO), con la Sezione insegnamento medio (SIM) e con il Dipartimento formazione e apprendimento (DFA).

1.2 Definizione del contenuto delle prove standardizzate

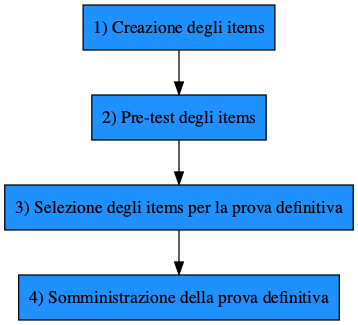

La prima fase del progetto, sino ad agosto 2019, è stata dedicata alla definizione dei contenuti da testare e all’identificazione delle persone che avrebbero potuto sviluppare gli item. La scelta dei settori da investigare è fondamentale in quanto sarebbe estremamente difficoltoso valutare contemporaneamente tutte le competenze presenti in una disciplina insegnata e farlo in modo esatto.

Nell’elaborazione della prova sono stati presi in considerazione, attingendoli dal Piano di studio della scuola dell’obbligo ticinese («Piano di studio della scuola dell’obbligo ticinese» 2015) gli ambiti di competenza che si è deciso di valutare per la matematica e per l’italiano. Nello specifico, per la matematica i 3 ambiti di competenza che si è deciso di valutare sono: Numeri e calcolo, Grandezze e misure e Geometria. Per l’italiano sono invece stati valutati i 2 ambiti di competenza: Leggere e Scrivere.

1.2.1 Matematica

Dell’ambito Numeri e calcolo si è misurato il processo cognitivo Matematizzare e modellizzare. Dell’ambito Grandezze e Misure sono state misurate i processi cognitivi Eseguire e applicare e Sapere e riconoscere. Infine, dell’ambito Geometria è stata misurata il processo cognitivo Sapere e riconoscere e i processi cognitivi Matematizzare e modellizzare e Comunicare e argomentare.

Le sei dimensioni testate sono quindi:

Numeri e calcolo – Matematizzare e modellizzare (NC MT)

Grandezze e misure – Eseguire e applicare (GM EA)

Grandezze e misure – Sapere e riconoscere (GM SRD)

Geometria – Sapere e riconoscere (GEO SRD)

Geometria - Matematizzare e modellizzare (GEO MM)

Geometria - Comunicare e argomentare (GEO CA)

1.2.2 Italiano

Di entrambi gli ambiti (i.e., Leggere e Scrivere) si è testato il processo “Attivare”. Dell’ambito di competenza Leggere è stato trattato il processo Realizzare, mentre dell’ambito di competenza Scrivere si è anche misurato il processo Rivedere.

Gli item presenti nelle prove sono stati suddivisi in due parti:

La Parte base (definita dall’acronimo PB), la quale racchiude esercizi che toccano l’ambito di competenza Leggere, valutandone gli Aspetti linguistici (processo Attivare), le Inferenze (processo Realizzare) e il Lessico (processo Attivare)

La parte aggiuntiva, la quale racchiude esercizi di tre singole dimensioni: Punteggiatura (P), Ortografia (O) e Metacognizione (M). Gli item di Punteggiatura toccano l’ambito di competenza Leggere, valutandone il processo Attivare. Gli item di Ortografia toccano l’ambito di competenza Scrivere, valutandone i processi Attivare e Rivedere. Gli item di Metacognizione toccano i processi testati nelle altre aree, lavorando sulla consapevolezza e la riflessione.

Successivamente, sono stati sviluppati gli item per testare ognuna delle parti stabilite. Nel costruire gli item si è dovuto tener conto di alcune indicazioni. In primo luogo ogni item doveva essere quanto più possibile mono dimensionale. Il lavoro in questa fase è stato svolto in stretta collaborazione con gli esperti di Didattica della Matematica operanti all’interno del DECS e del DFA. Per poter misurare la capacità di discriminazione dell’item (si parla di capacità discriminativa relativamente al fatto che l’item riceva risposte corrette dagli allievi più abili e scorrette da quelli meno abili) e anche la sua coerenza con la dimensione che si desiderava valutare; (è infatti necessario che ogni item sia attinente, in maniera completa o quantomeno prevalente, a una e una sola dimensione). Questa caratteristica rende questi item in sé differenti da quelli che normalmente sono utilizzati dai docenti durante la loro attività professionale. In secondo luogo, si è dovuto creare un numero di item sovrabbondante rispetto all’uso finale. Si è dovuto infatti prevedere che successivamente alla prova campione (fase di pre-test) sarebbe stato eliminato almeno il 30% degli item prodotti.

1.3 Metodologia di analisi

Il modello di analisi che è stato utilizzato per la valutazione e la selezione degli item (nella fase di pre-test) e per la definizione dei punteggi degli allievi è legato alla Item Response Theory (IRT) ed è costruito al fine di avere delle misure precise di costrutti ben definiti e quanto più possibili unitari. I modelli IRT sono una valida alternativa ai modelli di misura basati sulla Classic Test Theory (CTT). I modelli IRT corrispondono ad un approccio psicometrico che considera che la risposta di un individuo ad un particolare item sia influenzato dalle qualità dell’item (i.e., difficoltà1) e dalle caratteristiche individuali (i.e., competenza individuale sul costrutto latente misurato). In altri termini, i modelli IRT postulano che la probabilità di risposta corretta ad un item dipenda congiuntamente dall’abilità o competenza dell’individuo e dalla difficoltà dell’item2.

Nello specifico le analisi si sono svolte all’interno del quadro concettuale del modello di Rasch a un parametro (i.e., 1PL) che fornisce un modello di misura appropriato al contesto di questo progetto e che permette di trattare degli item dicotomici (i.e., items la cui risposta può essere giusta vs. sbagliata). Tutte le analisi presenti in questo rapporto sono state effettuate tramite R (R Core Team 2020). Le analisi IRT sono state realizzate tramite la libreria TAM (Robitzsch, Kiefer, e Wu 2021) mentre le varie operazioni di gestione dei database sono state realizzate con l’ausilio del corpo di librerie di tidyverse (Wickham et al. 2019).

1.4 Il pre-test

Una volta prodotti gli item e sottoposti a verifica di contenuto con l’assistenza degli esperti, si è proceduto alla preparazione della prova per il pre-test. Questa prova aveva lo scopo di valutare la pertinenza degli item e di individuare quelli più efficaci a misurare e a discriminare. Ordinandoli per difficoltà crescente si dovrebbe trovare un numero inizialmente molto elevato di allievi che risponderà correttamente e questo numero dovrebbe ridursi al crescere della difficoltà degli item stessi. Se un item ad esempio riceverà un numero di risposte corrette elevato ma solo dagli allievi meno abili, questo sarà scartato, parimenti saranno eliminati gli item non discriminanti, quelli cioè ai quali tutti o nessuno avranno risposto in modo corretto. Queste procedure hanno infatti lo scopo di costruire delle scale valide non in termini astratti ma all’interno delle popolazioni reali. Gli item costruiti sono infatti coerenti con i contenuti presentati nei programmi della scuola dell’obbligo ticinese e la loro difficoltà è valutata rispetto agli allievi dello stesso sistema scolastico. Concretamente, sono stati realizzati dieci differenti fascicoli, ciascuno di essi richiedeva un tempo di risposta di 45 minuti. Questa distribuzione apparentemente complessa era necessaria per garantire che ogni item fosse testato su almeno 300 allievi e ogni allievo venisse confrontato con 2 fascicoli, l’uno a distanza di una settimana dall’altro. La distanza di una settimana è stata ritenuta quella minima per poter ritenere l’effetto di apprendimento residuale. Ogni allievo ha quindi ricevuto due fascicoli diversi assegnati casualmente.

La somministrazione è stata curata da personale appositamente formato, il quale si è occupato di portare le prove nelle singole classi, far eseguire il lavoro agli allievi e recuperare poi i materiali distribuiti. Quest’ultima fase è estremamente rilevante in quanto gli esercizi proposti in questa fase dei lavori non hanno ancora subito alcun processo di validazione e non possono essere ritenuti efficaci alla valutazione delle competenze specifiche, non essendoci infatti valori che ne indichino l’efficacia o la difficoltà in alcun modo. Si deve anche sottolineare come un esercizio diffuso anticipatamente alla prova e/o in maniera non corretta (ad esempio tramite fotocopie del materiale) potrebbe rendere l’attività di valutazione non valida, in quanto introdurrebbe una condizione di non equità di fronte alla prova. Un problema più ampio legato alla disponibilità degli esercizi è quello definito in letteratura “teaching for testing” (Flukiger, 2004).

Le risposte degli allievi alle due prove (i.e., matematica ed italiano) sono poi state inserite in un archivio al fine di poter valutare la bontà metrica degli esercizi. I singoli esercizi, le scale e l’insieme degli esercizi sono stati quindi valutati utilizzando il modello di Rasch, al fine di capire come costruire le successive prove e quali esercizi conservare. Queste analisi hanno permesso di identificare gli items (i.e., domande) definitivi che possedevano le caratteristiche metriche desiderate. Per la matematica sono stati selezionati 144 items divisi nei 6 settori, mentre per l’italiano sono stati selezionati 228 items divisi nei 4 settori.

1.5 La prova definitiva somministrata

Gli items selezionati sono stati successivamente utilizzati per la concezione delle due prove definitive. Sia per matematica che per italiano, sono stati concepiti una serie di fascicoli cartacei contenenti gli items in ordine crescente di difficoltà3 Per matematica sono stati concepiti 6 fascicoli diversi contenenti ognuno items appartenenti a tutti i 6 settori identificati. Per italiano sono stati invece concepiti 2 fascicoli contenenti tutti e 4 i settori identificati. Come per la fase di pre-test si è deciso di far svolgere le attività di somministrazione esclusivamente a personale formato specificatamente, ciò anche per non portare un aggravio di lavoro al personale insegnante.

Le somministrazioni delle due prove di matematica ed italiano sono state effettuate in due sessioni distinte svoltesi a una settimana di distanza una dall’altra. In entrambe le sessioni, gli studenti hanno risposto a un fascicolo di matematica e a un fascicolo di italiano.4

Una volta raccolte le prove, gli item sono stati nuovamente sottoposti ad una analisi relativa alla identificazione della difficoltà rispetto alla popolazione degli allievi e, sulla base di questi valori, sono state successivamente svolte le analisi. Nel periodo estivo sono stati elaborati i rapporti delle singole classi e consegnati a docenti e direttori. Ogni docente ha ricevuto un rapporto relativo alla sua classe nel quale si mostrava per la classe e per ogni allievo relativamente ad ogni singolo settore il punteggio medio rispetto all’insieme della popolazione testata (media del Cantone). Analogamente ai direttori sono stati inviati i rapporti relativi all’istituto di competenza. Nel capitolo relativo alle analisi verranno presentati i dati raccolti secondo tre punti di osservazione differenti: il territorio, le classi e gli allievi.

La prova definitiva (di italiano e matematica) è stata somministrata a tutta la popolazione di allievi ticinesi di quinta elementare (N = 3043). Nel presente rapporto vengono presentati i risultati degli allievi che hanno partecipato ad entrambe le sessioni di somministrazione e risposto ad entrambi i fascicoli di matematica e italiano (n = 2506).

Si deve sottolineare che in funzione dei tipo di modello IRT utilizzat si possono anche considerare altri parametri degli items, come ad esempio il coefficiente di discriminazione, che possono influenzare la probabilità di fornire una risposta corretta.↩︎

Ad esempio, un individuo con un alto livello di abilità matematica avrà più probabilità di rispondere correttamente a un item di matematica rispetto a un individuo con un basso livello di abilità matematica. Inoltre, a parità di abilità, la probabilità di rispondere correttamente ad un item semplice è più alta rispetto alla probabilità di rispondere ad un item difficile↩︎

La difficoltà degli items è stata valutata durante la fase del pre-test.↩︎

L’ordine di presentazione dei fascicoli (matematica - italiano vs. italiano-matematica) è stato controbilanciato, di modo che se uno studente alla prima sessione ha risposto prima al fascicolo di matematica e poi a quello di italiano, alla seconda somministrazione ha risposto prima al fascicolo di italiano e poi a quello di matematica e viceversa. L’ordine di presentazione controbilanciato permette di controllare un eventuale effetto di fatica (Borgonovi, & Biecek, 2016).↩︎